Hati-Hati, Modus Penipuan Terbaru Pakai AI Ini Sudah Banyak Korbannya

Penipu memanfaatkan teknologi canggih untuk memanipulasi data, suara, dan gambar, sehingga sulit dideteksi.

Di era digital yang semakin canggih, penjahat siber terus mengembangkan taktik mereka. Salah satu ancaman yang patut diwaspadai adalah penipuan yang memanfaatkan kecerdasan buatan (AI).

Laporan terbaru menunjukkan peningkatan signifikan dalam kasus penipuan berbasis AI. Para pelaku menggunakan teknologi ini untuk memanipulasi data, suara, dan gambar, menciptakan skenario palsu yang sangat meyakinkan.

Lalu, apa saja modus penipuan yang memanfaatkan AI dan bagaimana cara menghindarinya? Berikut adalah lima modus penipuan terbaru yang menggunakan AI yang perlu Anda ketahui agar tidak menjadi korban.

Deepfake dan Serangan Email Bisnis (BEC)

Penipu menggunakan AI untuk membuat video dan audio palsu yang sangat meyakinkan. Mereka menyamar sebagai atasan atau rekan kerja melalui panggilan video (misalnya, Zoom) untuk memerintahkan transfer dana.

Di Amerika Serikat, 53% profesional akuntansi pernah menjadi target serangan email bisnis (BEC). Menariknya, 40% email BEC dibuat sepenuhnya oleh AI. Ini menunjukkan betapa canggihnya teknologi AI dalam meniru gaya bahasa dan pola komunikasi seseorang.

Modus ini sangat berbahaya karena sulit dibedakan dari interaksi yang asli. Korban seringkali tidak menyadari bahwa mereka sedang berinteraksi dengan deepfake hingga dana sudah ditransfer ke rekening penipu.

Chatbot Penipu Asmara

Chatbot AI otonom digunakan untuk merayu korban secara online. Percakapan yang natural dan tanpa aksen membuat korban sulit membedakan antara manusia dan bot. Modus ini telah muncul di media sosial dan bahkan diungkap oleh pelaku kejahatan di Nigeria.

Chatbot ini dirancang untuk membangun hubungan emosional dengan korban. Mereka menggunakan teknik manipulasi psikologis untuk mendapatkan kepercayaan korban dan akhirnya meminta uang atau informasi pribadi.

Salah satu tantangan dalam mendeteksi chatbot penipu asmara adalah kemampuan mereka untuk beradaptasi dengan gaya komunikasi korban. Mereka dapat meniru minat dan preferensi korban, membuat percakapan terasa sangat personal.

"Pig Butchering" dengan AI Massal

Skema penipuan investasi berkedok asmara atau bisnis ini dilakukan secara massal menggunakan AI. Pesan-pesan massal dikirim melalui platform seperti Instagram untuk memancing korban. Deepfake juga digunakan untuk panggilan video dan kloning suara agar lebih meyakinkan.

"Pig butchering" adalah istilah yang digunakan untuk menggambarkan proses penipuan yang melibatkan pembangunan hubungan emosional dengan korban sebelum akhirnya menipu mereka untuk berinvestasi dalam skema palsu.

AI digunakan untuk mengotomatiskan proses ini, memungkinkan penipu untuk menargetkan ribuan korban sekaligus. Pesan-pesan yang dipersonalisasi dan deepfake digunakan untuk meningkatkan kepercayaan korban dan membuat mereka lebih mungkin untuk berinvestasi.

Penipuan Suara dan Video Call AI

Penipu mengumpulkan rekaman suara korban dari platform online, lalu membuat replika suara tersebut untuk menghubungi kerabat atau teman korban, berpura-pura menjadi mereka dan meminta uang. Sekitar 750 orang di Inggris menjadi korban dalam 12 bulan terakhir.

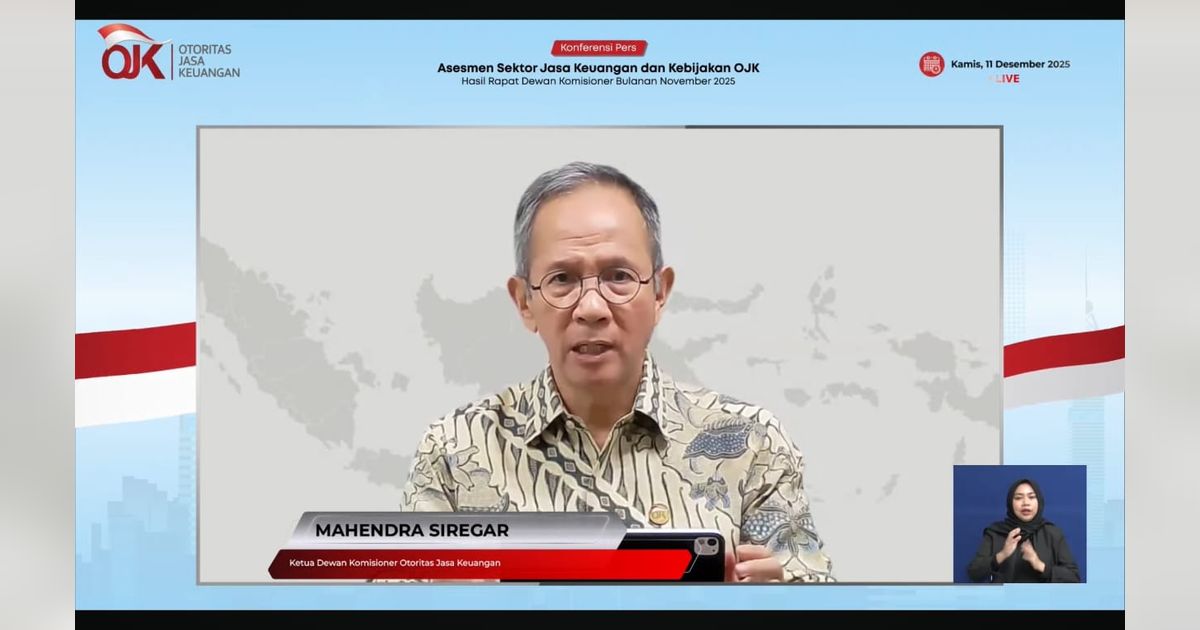

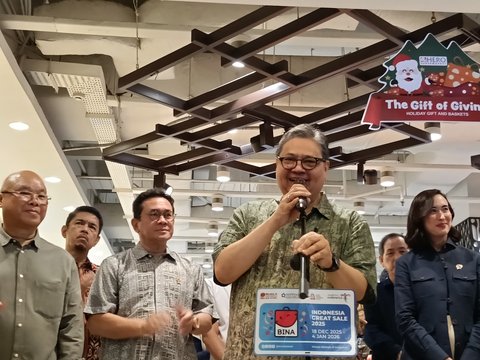

Dalam penipuan video call, penipu menggunakan AI untuk membuat panggilan video palsu, menampilkan wajah dan suara selebriti atau orang yang dikenal korban. Korban diiming-imingi hadiah atau diminta untuk mentransfer uang. Kasus ini telah terjadi di Indonesia dan negara lain, dengan lonjakan kasus yang signifikan.

Modus ini sangat efektif karena memanfaatkan kepercayaan dan emosi korban. Ketika korban menerima panggilan dari seseorang yang mereka kenal atau kagumi, mereka cenderung lebih percaya dan kurang waspada.

Cara Menghindari Penipuan Berbasis AI

- Waspada terhadap panggilan tak dikenal: Jangan langsung percaya pada panggilan video atau telepon dari nomor yang tidak dikenal, terutama jika meminta uang atau informasi pribadi.

- Verifikasi identitas: Selalu verifikasi identitas penelepon atau pengirim pesan melalui cara lain, seperti menghubungi langsung orang yang bersangkutan melalui nomor yang sudah dikenal.

- Perhatikan detail: Perhatikan detail dalam percakapan, seperti aksen, kecepatan bicara, dan kualitas suara atau video. Kejanggalan bisa menjadi indikasi deepfake.

- Gunakan kata kunci rahasia: Sepakati kata kunci rahasia dengan keluarga dan teman dekat untuk memverifikasi identitas mereka.

- Hati-hati dengan informasi online: Batasi informasi pribadi yang diunggah di platform online, termasuk rekaman suara dan video.

- Laporkan penipuan: Jika Anda menjadi korban penipuan, segera laporkan ke pihak berwajib dan lembaga terkait.

:strip_icc()/kly-media-production/medias/5482909/original/015476000_1769280724-alex_jimenez_gol_bouremouth_liverpool_ap_ian_walton.jpg)

:strip_icc()/kly-media-production/medias/5484549/original/008721900_1769445417-camat_medan_maimun.jpg)

:strip_icc()/kly-media-production/medias/5484245/original/046238700_1769417705-4.jpg)

:strip_icc()/kly-media-production/medias/4858180/original/029627600_1717939832-WhatsApp_Image_2024-05-29_at_10.56.30.jpeg)

:strip_icc()/kly-media-production/medias/5484497/original/057677900_1769433870-167338.jpg)

:strip_icc()/kly-media-production/medias/5481615/original/091930400_1769139822-3.jpg)